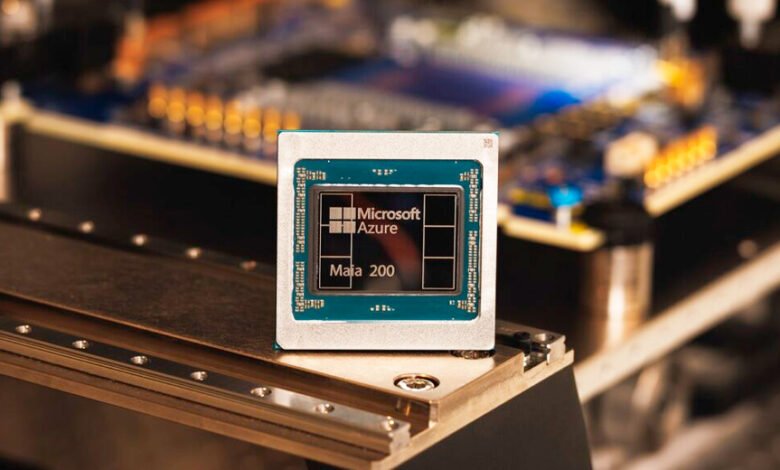

Maia 200: El acelerador de IA diseñado para la inferencia

Maia 200 es el acelerador de IA de próxima generación de Microsoft da a Azure una ventaja para ejecutar modelos de IA de forma más rápida y rentable.

Microsoft está de manteles largos al presentar Maia 200, un acelerador de inferencia revolucionario diseñado para mejorar de manera importante la economía de la generación de tokens con IA. Maia 200 es una potencia en inferencia de IA: un acelerador construido sobre el proceso de 3nm de TSMC con núcleos tensoriales nativos FP8/FP4, un sistema de memoria rediseñado con 216GB HBM3e a 7 TB/s y 272MB de SRAM integrada, además de motores de movimiento de datos que mantienen los modelos masivos alimentados, rápidos y con una alta utilización.

Esto convierte a Maia 200 en el silicio de primera mano más eficiente de cualquier hiperescalador, con tres veces el rendimiento FP4 del Amazon Train de tercera generación y un rendimiento FP8 superior al TPU de séptima generación de Google. Maia 200 es también el sistema de inferencia más eficiente que Microsoft ha desplegado jamás, con un 30% de rendimiento por dólar superior al hardware de última generación de nuestra flota actual.

Maia 200 forma parte de nuestra heterogénea infraestructura de IA y servirá para múltiples modelos, incluidos los últimos modelos GPT-5.2 de OpenAI, para aportar una ventaja de rendimiento por dólar a Microsoft Foundry y Microsoft 365 Copilot.

El equipo de Microsoft Superintelligence utilizará Maia 200 para la generación de datos sintéticos y el aprendizaje por refuerzo para mejorar los modelos internos de próxima generación. Para casos de uso de pipelines de datos sintéticos, el diseño único de Maia 200 ayuda a acelerar la velocidad a la que se pueden generar y filtrar datos de alta calidad y específicos de dominio, para alimentar la formación posterior con señales más frescas y específicas.

Maia 200 está desplegado en nuestra región de centros de datos US Central, cerca de Des Moines, Iowa, con la región de centros de datos US West 3 cerca de Phoenix, Arizona, a continuación y futuras regiones que vendrán después. Maia 200 se integra a la perfección con Azure, y presentamos el SDK de Maia con un conjunto completo de herramientas para construir y optimizar modelos para Maia 200. Incluye un conjunto completo de capacidades, incluida la integración con PyTorch, un compilador Triton y una biblioteca optimizada del kernel, así como acceso al lenguaje de programación de bajo nivel de Maia. Esto ofrece a los desarrolladores un control detallado cuando es necesario, al tiempo que facilita el portabilidad de modelos a través de aceleradores de hardware heterogéneos.

Diseñado para la inferencia de IA

Fabricado con el avanzado proceso de 3 nanómetros de TSMC, cada chip Maia 200 contiene más de 140 mil millones de transistores y está adaptado para cargas de trabajo de IA a gran escala, además de ofrecer un rendimiento eficiente por dólar. En ambos aspectos, Maia 200 está diseñado para destacar. Está diseñado para los modelos más recientes que utilizan computación de baja precisión, con cada chip Maia 200 que entrega más de 10 petaFLOPS en precisión de 4 bits (FP4) y más de 5 petaFLOPS de rendimiento de 8 bits (FP8), todo dentro de un envolvente TDP SoC de 750W. En términos prácticos, Maia 200 puede correr sin esfuerzo los modelos más grandes de hoy, con mucho margen para modelos aún más grandes en el futuro.

Sistemas de IA optimizados

Una capa de transporte personalizada y una tarjeta de red integrada de manera estrecha desbloquean rendimiento, gran fiabilidad y ventajas de coste significativas sin depender de tejidos propietarios.

Cada acelerador expone:

- 2,8 TB/s de ancho de banda bidireccional dedicado a escalar

- Operaciones colectivas predecibles y de alto rendimiento en clústeres de hasta 6.144 aceleradores

Esta arquitectura ofrece un rendimiento escalable para clústeres de inferencia densos mientras reduce el consumo de energía y el costo total de atención al consumo total de energía en toda la flota global de Azure.

Dentro de cada bandeja, cuatro aceleradores Maia están conectados por completo con enlaces directos y no conmutados, para mantener la comunicación de alto ancho de banda local, lo que permite una eficiencia óptima de inferencia.

Los mismos protocolos de comunicación se utilizan para redes intra-rack e inter-rack por medio del protocolo de transporte AI-AI, lo que permite una escalabilidad fluida entre nodos, racks y clústeres de aceleradores con saltos mínimos en red.

Este tejido unificado simplifica la programación, mejora la flexibilidad de la carga de trabajo y reduce la capacidad bloqueada, lo que mantiene al mismo tiempo un rendimiento y eficiencia de costes consistentes a escala en la nube.

Un enfoque de desarrollo nativo en la nube

Un principio fundamental de los programas de desarrollo de silicio de Microsoft es validar la mayor parte posible del sistema de extremo a extremo antes de la disponibilidad final del silicio.

Un sofisticado entorno pre-silicio guio la arquitectura Maia 200 desde sus primeras etapas, para modelar los patrones de cálculo y comunicación de los LLMs con alta fidelidad. Este entorno temprano de co-desarrollo nos permitió optimizar el silicio, las redes y el software de sistema como un todo unificado, mucho antes del primer silicio.

También diseñamos Maia 200 para una disponibilidad rápida y fluida en el centro de datos desde el principio, para construir la validación temprana de algunos de los elementos más complejos del sistema, incluida la red backend y nuestra Unidad de Intercambiador de Calor de Refrigeración líquida de segunda generación, en circuito cerrado.

La integración nativa con el plano de control de Azure ofrece seguridad, telemetría, diagnóstico y capacidades de gestión tanto a nivel de chip como de rack, lo que maximiza la fiabilidad y el tiempo de actividad para cargas de trabajo críticas en producción de IA.

Como resultado de estas inversiones, los modelos de IA funcionaban con silicio Maia 200 a los pocos días de la llegada de la primera pieza empaquetada. El tiempo desde el primer silicio hasta el primer despliegue en racks de centros de datos se redujo a menos de la mitad que el de programas de infraestructura de IA comparables.

Y este enfoque de extremo a extremo, desde el chip hasta el software y el centro de datos, se traduce de manera directa en una mayor utilización, tiempos de producción más rápidos y mejoras sostenidas en el rendimiento por dólar y por vatio a escala de nube.

Regístrense para la vista previa del SDK de Maia

La era de la IA a gran escala apenas comienza, y la infraestructura definirá lo que es posible. Nuestro programa acelerador de IA Maia está diseñado para ser multigeneracional. A medida que desplegamos Maia 200 en toda nuestra infraestructura global, ya hemos comenzado a diseñar para las futuras generaciones y esperamos que cada generación establezca de manera continua nuevos estándares para lo que es posible y ofrezca un rendimiento y eficiencia cada vez mejores para las cargas de trabajo de IA más importantes.

Microsoft invita a desarrolladores, startups de IA y académicos a comenzar a explorar la optimización temprana de modelos y cargas de trabajo con el nuevo kit de desarrollo de software (SDK, por sus siglas en inglés) Maia 200.

El SDK incluye un compilador Triton, soporte para PyTorch, programación de bajo nivel en NPL y un simulador Maia y calculadora de costes para optimizar eficiencias más temprano en el ciclo de vida del código. Regístrense para la vista previa aquí.